Worüber sich Atheisten und Theisten einigen können

Es sollte möglich sein, ein minimales Axiomensystem aufzustellen, dem sowohl Theisten wie auch Atheisten zustimmen. Ich werde diesen Versuch wagen und gebe hiermit eine Liste an, mit der beide Personengruppen (hoffentlich) leben können:

- Die Gültigkeit der Logik zur Beschreibung der Realität

- Bevorzuge die Plausibilität mathematisch wahrscheinlicherer Sachverhalte gegenüber unwahrscheinlicheren

- „Deal with the evidence“, d.h. vermeide Spekulationen, wenn unnötig („Occam’s Razor“)

- Die Gültigkeit des Kausalitätsprinzip („Keine Wirkung ohne Ursache” oder auch „Aus Nichts kommt Nichts“)

- Die aktuellen Erkenntnisse der Naturwissenschaften sind „das Beste“ was wir zur Zeit haben, daher sollten diese Berücksichtigung finden, wenn auch nicht dogmatisch

Mit diesen Minimalanforderungen sollte es gelingen, die Rationalität von Atheismus oder Theismus hinreichend zu beurteilen. Leider ist gerade Punkt 1 oft vernachlässigt. Selbst große Naturwissenschaftler und Philosophen sind nicht davor geschützt, elementare logische Fehler zu machen. Ein wunder Punkt sind dabei Selbstwidersprüche, die sich „unbemerkt“ einschleichen und ganze Theorien zum Kippen bringen können. Ein auf den ersten Anblick so schön wirkender Satz wie „Weil es keine absoluten moralischen Werte gibt, soll man die relativen moralischen Werte jeder Kultur tolerieren“ ist ein gutes Beispiel für eine selbstwidersprüchliche Aussage. Das Problem hiermit ist, dass die Behauptung, etwas „tolerieren zu sollen“ selbst ein moralischer Wert darstellt („nicht tolerant“ zu sein ist übrigens ebenfalls ein moralischer Wert). Gemäß des ersten Teil des Satzes ist dies kein absoluter, sondern auch nur ein relativer moralischer Wert. Nun gibt es aber Kulturen, die das Gegenteil glauben, also dass man die Werte andere Kulturen nicht tolerieren soll. Dieser moralische Wert der Kultur müsste nach der Aussage des Satzes auch toleriert werden und widerspricht so der Aussage des Satzes. Es wird also mit solchen Aussagen implizit unterstellt, dass das „tolerieren sollen“ ein absoluter moralsicher Wert darstellt, was aber im ersten Teil des Satzes gerade verneint wird. Verneint man die Existenz absoluter moralischer Werte, so hat man ohnehin Probleme mit der Benutzung von Worten wie „man soll“ oder „es ist besser wenn“ etc.

Ein anderes, offensichtlicheres Beispiel für selbstwidersprüchliche Aussagen ist die Behauptung eines meiner Studenten: „Über Gott kann man keine Aussagen machen“. Dies ist offensichtlich selbstwidersprüchlich, denn die Behauptung ist selbst bereits eine Aussage über Gott.

Dies spielt auch bei „Axiom“ 4 eine Rolle. Der weltberühmte atheistische Philosoph Paul Kurtz, Mitverfasser des Humanistischen Manifests I und II[1], hat beispielsweise in einer Debatte mit dem Apologetiker Norman Geisler[2] unter Hinweis auf das Kausalitätsprinzip die selbstwidersprüchliche Frage gestellt: „Wer hat Gott erschaffen?“. Kurtz meinte, da Gott unbestreitbar eine „Wirkung“ sei, müsse auch er gemäß des Kausalitätsprinzips eine Ursache haben. Es handelt sich dabei natürlich um einen groben, in der Logik auch „Kategorischer Fehler“ genannten Missgriff. Aus der Logik folgt nämlich, dass das Kausalitätsprinzip nur anwendbar ist auf die Kategorie von Wirkungen, die irgendwann „in Existenz“ gekommen sind. Das heißt, das Kausalitätsprinzip kann auch so formuliert werden: „Alles was in Existenz kommt, hat eine Ursache“. Der Beweis ist trivial: Wenn etwas Existierendes nicht in Existenz kam, gibt es nur eine Möglichkeit: Es muss schon von Ewigkeit her existieren. Was aber schon ewig existiert, kann nicht erschaffen worden sein, ist also unverursacht. Da (zumindest der biblische) Gott schon von Ewigkeit her existiert, ist die Frage nach seinem Verursacher ein logischer Selbstwiderspruch bzw. ein unzulässiger Kategoriewechsel. Man ist daher auf der „sicheren Seite“, wenn man das Kausalitätsprinzip in seiner redundanteren Form „Alles was in Existenz gekommen ist, hat eine Ursache“ formuliert.

Meine These ist nun: Wenn die o.g. 5 „Axiome“ akzeptiert werden, dann muss Atheismus falsch sein. Ich gehe sogar soweit zu behaupten, dass bereits die Akzeptanz eines einzigen (beliebigen) der Axiome 2-5 ausreicht, um Atheismus zu widerlegen. (Ich nehme an, dass keiner die Gültigkeit von Axiom 1 bezweifelt, sonst wäre bereits jeder Satz den Menschen denken, sprechen oder schreiben äquivalent zu „grmf glibber blabla“ oder sonst einer beliebigen Buchstabenkombination). Die Ablehnung von Axiom 1 wäre übrigens wieder ein Beispiel für Selbstwiderspruch, denn die Behauptung der Ungültigkeit von Axiom 1 ist selbst eine logische Aussage. Axiom 1 behauptet im Übrigen nicht, dass Logik die einzige Beschreibung der Realität ist. Realität kann auch durch Gefühle, Kunst oder spirituelle Erfahrung beschrieben werden. Davon bleibt aber die Richtigkeit des Axioms 1 nicht betroffen.

Was uns die aktuelle Naturwissenschaft lehrt

Zunächst einmal ist zwischen naturwissenschaftlichen DATEN und THEORIEN zu unterscheiden. Einmal (unterstellt richtig) gemessene Daten unterliegen nicht dem naturwissenschaftlichen Wandel. Naturwissenschaftliche Theorien kommen und gehen, doch Daten bleiben bestehen. So sind die Messergebnisse Newtons damals wie heute und auch in Zukunft richtig. Gewandelt hat sich ihre theoretische Interpretation. Die Newton’sche Physik, die um die Daten seinerzeit „herum gebastelt“ wurde, machte solange gute Vorhersagen (und wurde als „richtig“ interpretiert), bis neuere Messungen nicht mehr mit den Vorhersagen der Newton’schen Theorie übereinstimmten (z.B. das Michelson-Morley-Experiment Ende des 19. Jahrhunderts). Neue Theorien verfeinern die alten („Korrespondenzprinzip“); so verfeinerte die Relativitätstheorie Einsteins die Newton’sche Physik. Das Problem aller Naturwissenschaft ist, dass sie die mehr oder weniger „absoluten“ Daten, die man messen kann, mit „relativ richtigen“ naturwissenschaftlichen Theorien interpretiert. Wobei eine naturwissenschaftliche Theorie eigentlich zwei Bestandteile hat: einen wirklich immer absolut „richtigen“ Teil, nämlich die Logik (z.B. der Mathematik), und den „relativen“ Teil, nämlich die zur Zeit der Aufstellung der Theorie nicht beweisbaren Grundannahmen (Prämissen). Nun weiß jeder Erstsemester-Logik-Student, dass eine Schlussfolgerung nur dann sicher wahr ist, wenn die Prämissen wahr sind. Sind die Prämissen falsch, kann zwar die Schlussfolgerung („zufällig“) auch wahr sein, doch das kann nicht garantiert werden. Deswegen sind Wissenschaftler natürlich stark daran interessiert, möglichst Prämissen zu treffen, deren Wahrheit und Richtigkeit zumindest hochwahrscheinlich und plausibel ist. Der mathematisch-logische Teil von Netwon’s Physik war und ist immer noch zu 100% richtig. Falsch war seine Prämisse, dass Raum und Zeit absolut seien. Solange diese Annahme in einem Problemfeld keine Rolle spielt, kann Newtons Physik auch heute noch benutzt werden (was sie ja auch noch wird, z.B. im Bauingenieurwesen etc.).

Um diesem Problem weitgehend zu entgehen, möchte ich auch nicht so sehr auf Theorien, sondern vielmehr auf messbare Daten in Kombination mit Logik zurückgreifen. Und insbesondere die Daten, die heute mit der Theorie der Quantenmechanik so gut erklärt werden, sind dabei sehr bemerkenswert, geben sie uns doch tiefe Einblick in die Struktur unserer Welt. Dies führt u.a. zu den nachfolgenden Schlussfolgerungen.

„Reale“ Unendlichkeiten sind physikalisch nirgends zu beobachten

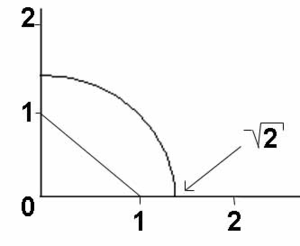

Was in der Mathematik gang und gäbe ist, scheint in der realen Welt nicht messbar: die Unendlichkeit. Man hat gemessen, im Großen und im Kleinen, doch man findet sie nirgends. Im Großen kann man nur messen, dass das Universum sich ausdehnt. Es gibt also eine „endliche“ Grenze die sich ständig „nach außen“ (was immer das außerhalb des Universum auch sein mag) fortbewegt. Noch schlimmer ist es im Kleinen: Alle Messungen deuten an, dass es eine „kleinste“ Einheit sowohl im Raum wie auch in der Zeit gibt. Was für Materie, Licht, Energie, Elektrizität etc. schon längst bestätig ist, scheint auch nach allem was man messen kann für den „leeren“ Raum zu gelten: die Quantisierung. Das „kleinste Stück“ leerer Raum hat eine Kantenlänge von rund 10-33 cm und die „kürzeste“ Zeit, die vergehen kann, ist ungefähr 10-43 Sekunden „lang“ (Planck-Länge und –Zeit). Alle zur Zeit verfügbaren DATEN weisen also in Richtung Quantisierung der Welt. THEORIEN arbeiten dagegen noch mit Kontinuitäten, da diese ursprünglich in der Mathematik so vorhanden sind. Mathematisch kann man eine Tafel Schokolade unendlich oft halbieren, also die Hälfte der Hälfte der Hälfte etc. hervorbringen. Da alle Materie quantisiert ist, gelingt das in Realität natürlich nur bis zum kleinsten Masseteilchen (man nimmt heute an, dass das die sog. „Quarks“ sind). Mit leeren Räumen hoffte man auf dieses Problem nicht zu stoßen. Aber es scheint auch hier so zu sein, dass mit den Halbierungen eines leeren Raumes bei der Planck-Länge Schluss ist. Diese ist nicht halbierbar. In meiner Schulzeit hatten wir im Mathematikunterricht die „wirkliche“ Existenz irrationaler Zahlen so bewiesen (zur Erinnerung: eine irrationale Zahl hat unendlich viele Nachkommastellen): Man gehe hin, zeichne auf ein Blatt Papier eine x- und eine y-Achse mit cm-Einheiten. Dann verbinde man die Zahl „1“ auf der x-Achse mit der Zahl „1“ auf der y-Achse, bildet also ein Dreieck (vgl. Abb. 1).

Abb. 1: Die „Realität“ einer irrationalen Zahl

Der Abstand der beiden Einsen ist nach dem Satz des Pythagoras gerade die Wurzel aus 2, also eine irrationale Zahl, die sogar, nimmt man mit dem Zirkel diesen Abstand und macht einen Kreis um den Ursprung, „real“ auf der x-Achse, der Menge der reellen Zahlen, existiert.

In Realität existiert jedoch diese Zahl nicht. Da nur Vielfache von Plank-Längen möglich sind, ist es dem Zirkel nicht möglich, „zwischen“ zwei Plancklängen zu gelangen, was er aber müsste, wollte er „genau“ die Wurzel aus 2 zum Radius nehmen.

Was lernen wir also daraus? Unendlich Kleines und unendlich Großes existiert vermutlich in unserem physikalischen Universum nicht. Diese sind offenbar reine „Gedankenspiele“ der Mathematik. Der Mensch kann erstaunlicherweise Unendliches denken, doch es wird nicht vorgefunden in unserem Universum. Nach unseren Prämissen Nr. 2 und 3 muss also angenommen werden, dass es am Wahrscheinlichsten ist, dass in physikalischer Realität nichts Unendliches existiert. Da es keinerlei Evidenz für die Existenz von etwas physikalisch Unendlichem gibt, ist die Annahme, es gäbe etwas physikalisch Unendliches, extrem spekulativ (Axiom 3) und extrem unwahrscheinlich (Axiom 2).

Das Kausalitätsprinzip ist unabhängig von Raum und Zeit

Unsere Alltagserfahrung lehrt, dass die Reihenfolge von Ursache und Wirkung zeitgerichtet ist, und zwar so, dass die Ursache zeitlich vor der Wirkung stattfindet. Bis Ende der 70er Jahre des 20. Jahrhunderts war das auch in der messtechnischen Physik so. Die Quantenphysik hatte schon sehr früh vorhergesagt, dass es Phänomene geben kann, wo diese zeitliche Reihenfolge verletzt ist. Einstein lehnte u.a. deswegen die Quantenphysik ab, erkannte aber richtig, dass, wenn man jemals solche Messungen durchführen könnte (was er nicht glaubte), die Richtigkeit der Quantentheorie damit geprüft werden könne. Nun, heute kann man solche Messungen durchführen. Allan Aspect hat in den 80er Jahren des 20.

Jahrhundert einen Versuch durchgeführt[3], bei dem die räumliche Unabhängigkeit bzw. die Gleichzeitigkeit von Ursache und Wirkung demonstriert wurde. Er benutzt zwei sog. „verschränkte“ Teilchen (das sind eine Art Zwillingsteilchen, die gemeinsam erzeugt wurden und sich in einem bestimmten quantenphysikalischen („unbeobachteten“) Zustand befinden), die in entgegengesetzte Richtung davon fliegen. Misst man nun den Drehimpuls eines der Teilchen (Ursache), so wird ohne Zeitverlust über eine beliebige Distanz hinweg der Drehimpuls des anderen Teilchens „festgelegt“ (Wirkung). Aus Aspects Messaufbau folgt also, dass das Kausalitätsprinzip auch gleichzeitig und räumlich unabhängig richtig ist. Ursache und Wirkung finden gleichzeitig statt.

Doch damit nicht genug. Der Physiker Marlan Scully schlug einen Versuch vor, der später dann durchgeführt wurde, und der es ermöglichte, eine Ursache zeitlich nach der Wirkung

zu platzieren[4]. Hierbei wird ausgenutzt, dass jedes Teilchen aufgrund der Heisenbergschen Unschärferelation von einer relative großen „Wolke“ aus Orts- und Zeitunschärfe umgeben ist. Vor allem die Zeitunschärfe, welche die Wolke ein Stück in die Vergangenheit und Zukunft reichen lässt, wird bei Scully’s Experimenten ausgenutzt. Es ist nämlich möglich, einen Versuch aufzubauen, bei dem ein bestimmter Eingriff in der Gegenwart ein bestimmtes Verhalten in der Vergangenheit erzwingt (das sind die sog. „Delayed Choice” Experimente). Eine genauere Beschreibung solch eines Scully-Experiments ist z.B. in meinem Artikel „Genesis, Quantenphysik und Wirklichkeit“ im Professorenforum-Journal Vol. 1 No.1 (www.professorenforum.de) zu finden. Wichtig allein ist hier jedoch die Tatsache, dass das Scully-Experiment klar zeigt, dass das Kausalitätsprinzip auch entgegen der Zeitrichtung funktioniert. Das heißt, dass eine Ursache zeitlich nach der Wirkung liegen kann. Zusammenfassend zeigen diese physikalischen Experimente also zweifelsfrei, dass es

- Ursachen zeitlich vor der Wirkung

- Ursachen gleichzeitig mit der Wirkung

- Ursachen nach der Wirkung

- Ursachen und Wirkungen räumlich unabhängig voneinander

gibt.

Da es nur drei zeitliche Reihenfolgen gibt (vor, gleichzeitig, nach) und das Kausalitätsprinzip für alle drei Fälle gilt, ist es damit offenbar von der zeitlichen Reihenfolge prinzipiell unabhängig. Damit wird das Kausalitätsprinzip aber zu einem sog. „Meta-Prinzip“, da es Raum und Zeit transzendieren kann. Es sei an dieser Stelle noch Spekulationen entgegengetreten, dass das Kausalitätsprinzip in der Quantenphysik nicht gelte. Gemeint ist hier meistens, dass durch den der Quantenphysik scheinbar inhärenten Zufall das Kausalitätsprinzip nicht anwendbar sei. Doch wie selbst Stephen Hawking schreibt, ist der Determinismus durch die Quantenphysik nicht beseitigt, sondern im Gegenteil, er wird durch die Theorie wieder hergestellt[5]. Die gleiche Ursache löst einfach nicht immer die gleiche Wirkung aus, sondern ein mögliches Kontingent von Wirkungen, das ist alles.

Es existiert spezifische Komplexität in der Natur

Was unterscheidet die in den Mount Rushmore eingemeißelten 5 Präsidentenköpfe von einer vom Menschen unbearbeiteten und von Wind und Wetter zerfressenen Bergkette? Die Eiger Nordwand beispielsweise findet sich vermutlich im ganzen Universum genauso wenig wieder wie die Präsidentenköpfe in Mount Rushmore. Und beide Strukturen sind hochkomplex. Es handelt sich sicher in beiden Fällen um ein Unikat. Die Frage ist, ob es eine wissenschaftliche Methode gibt, die objektiv feststellen kann, dass bei Mount Rushmore „Design“ eines intelligenten (und künstlerisch begabten) Menschen im Spiel war. Und in der Tat hat der Mathematiker und Philosoph William A. Dembski ein solches Kriterium entwickelt[6]. Dieser „Dembski-Filter“ stellt ein mathematisch äußerst zuverlässiges „Netz“ dar, in dessen Maschen bisher nur durch Intelligenz hervorgebrachtes Design hängen geblieben ist und niemals ein durch Zufall entstandenes Muster (hinreichende Komplexität vorausgesetzt). In allen nachprüfbaren Fällen, wo Dembski’s Filter griff, war intelligentes Design im Spiel. Da tut sich natürlich die interessante Frage auf: Was ist mit den nicht nachprüfbaren Fällen? Also die Fälle, von denen ich nicht weiß, ob Design im Spiel ist. Nun, da bisher noch nie ein zufälliges Muster in den Maschen des Dembski-Filters hängen blieb (und derselbe schon hinlänglich getestet wurde), kann als wahrscheinlich angenommen werden, dass der Filter ein guter Test ist und zuverlässig arbeitet. Wendet man diesen Filter nun auf ein so komplexes Objekt wie eine menschliche Zelle an, so bleibt ein solches „Muster“ in Dembski’s Filter hängen. Der biologische Atheist redet deswegen davon, dass die Natur „Design nachbilde“ (nach welchem Vorbild?) und redet von „scheinbarem Design“. Nach der Evolutionstheorie ist dieses scheinbare Design durch Zufall entstanden. Dies widerspricht jedoch massiv jeder mathematischen Wahrscheinlichkeitslehre. Dembski’s Filter berücksichtigt zudem schon diese „Zufälle“. Außerdem gibt es eine sog. irrreduzible Komplexität

in der Mikrobiologie[7]. Dort gibt es äußerst komplexe zellbiologische „Maschinen“ die so gebaut sind, dass die gesamte Funktion der Maschine erlischt wenn auch nur ein einziges Teil der Maschine fehlt (daher irrreduzibel). Diese Maschinen sind jedoch so hochkomplex, dass sie zufällig niemals in der verfügbaren Zeit des Universums hätten entstehen können. Da ist es mathematisch gesehen bei weitem wahrscheinlicher, dass ein Tornado, der durch einen Schrottplatz weht, zufällig eine Boing 747 erschafft.

Gibt es eine „erste Ursache“ aller Dinge?

Es sei hier der Frage nachgegangen, was mathematisch wahrscheinlicher (und damit plausibler) ist: Die Annahme der Existenz eines intelligenten Schöpfers oder die Annahme, dass es keinen solchen gibt. Hierzu sei der Big Bang betrachtet, der als „Urknall“ unser Universum in Existenz brachte. Wenn wir uns nicht in logische Selbstwidersprüche verwickeln wollen, müssen wir nach dem Kausalitätsprinzip annehmen, dass das Universum verursacht wurde (siehe oben), denn es ist offenbar in Existenz gekommen.

Es sei hier angemerkt, dass vor den physikalischen Versuchen von Aspect und Scully die Atheisten mit Recht darauf verwiesen, dass das Kausalitätsprinzip nur innerhalb des Universums gelten würde und daher nicht notwendigerweise auf das Universum selbst angewendet werden könne, da man damit ggf. dessen Gültigkeitsbereich verlasse. Jetzt weiß man aber, dass es sich bei dem Kausalitätsprinzip um ein Meta-Prinzip handelt, das unabhängig von Raum und Zeit (die ja mit dem Universum erschaffen wurden) ist. Daher ist es plausibler anzunehmen, dass das Kausalitätsprinzip auch außerhalb der Raum-Zeit unseres Universum gilt als dies nicht anzunehmen.

Damit ist es aber auch plausibel anzunehmen, dass es eine Ursache für das Universum gibt. Diese Ursache kann nun wiederum selbst verursacht sein oder auch nicht. Wenn nicht, existiert sie schon ewig. Wenn selbst verursacht, kann das gleiche Spiel auf dessen Ursache angewendet werden. Am Schluss gibt es nur zwei Möglichkeiten: Entweder es gibt eine erste Ursache (die dann ewig existieren muss) oder es gibt eine unendliche Kette von Ursachen und Wirkungen. Betrachten wir zunächst letzteren Fall.

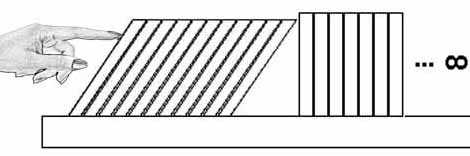

Wenn es eine unendliche Kette von Ursachen und Wirkungen gibt, dann kann höchstens nur eine endliche Teilmenge der Kette zeitbehaftet sein. Der unendliche Anteil dieser Art der Kausalität muss nun von der Sorte „Gleichzeitigkeit“ sein. Dies kann man so einsehen: Würde zwischen den Ursachen und Wirkungen eine (wenn auch noch so kleine) Zeitspanne verstreichen, wäre unser „hier und jetzt“ nie erreichbar. Als Analogie sei ein unendlich langes Buchregal betrachtet, dass zwar einen Anfang, jedoch kein Ende besitzt. Wir nehmen einmal an, das Buchregal erstreckt sich nach rechts von einem Beobachter weg (vgl. Abb. 2).

Abb. 2: Ein unendliches Buchregal mit Anfang, doch ohne Ende

So eine Buchreihe hat zwar einen Anfang (links) aber kein Ende (rechts). Würde man nun das erste Buch nach hinten umwerfen, so würde durch einen Domino-Effekt eine Kettenreaktion ausgelöst (ideale physikalische Bedingungen vorausgesetzt). Jedes umfallende Buch ist die Ursache des nächsten umfallenden Buches. Es ist natürlich klar, dass diese Umfallerei kein Ende nimmt, denn da das Buchregal unendlich lang ist wird auch unendlich viel Zeit benötigt, bis „das letzte“ Buch in der Unendlichkeit umfiele.

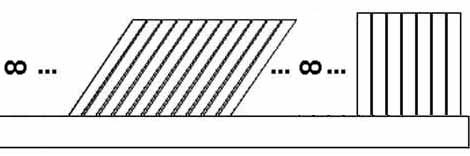

Angenommen, man dreht das Buchregal jetzt um 180 Grad nach links (was übrigens auch unendlich lange dauern würde). Und angenommen, die Bücher würden jetzt von der Unendlichkeit her umgeworfen, also vor ewiger Zeit wurde die „Kausal-Kette“ gestartet (vgl. Abb. 3).

Abb. 3: Ein unendliches Buchregal ohne Anfang, doch mit Ende

Da es sich sozusagen um das Spiegelbild des ersten Falles handelt, dauert es offenbar genau so lange bis alle Bücher umgefallen sind wie im ersten Fall, also ewig. Das heißt aber, dass das letzte Buch, vor dem Sie (jetzt rechts) stehen, nie umfallen wird, denn dafür müssten Sie unendlich lange warten. Analog müssten wir unendlich lange warten bis unser Universum entsteht, sollte es eine unendliche zeitbehaftete Kette von Ursachen und Wirkungen hierfür geben. Wir wären demnach also gar nicht da und könnten nicht darüber reden. Diese Möglichkeit muss also ausgeschlossen werden.

Damit bleibt aber allenfalls der Fall übrig, dass (fast) alle Ursachen und Wirkungen gleichzeitig stattfinden. Doch das kann aus folgenden Gründen auch nicht sein: Zumindest unser Universum braucht Zeit, die ja vergeht während Sie diesen Artikel lesen. Nun zeigt uns das Experiment von Allan Aspect, dass gleichzeitige Ursache und Wirkung nur dort zu finden ist, wo die Ursache und die Wirkung (wie bei den beiden Zwillingsteilchen) sich auf quantenmechanisch verschränkte Teilchen bezieht. Diese sind zunächst in einem ununterscheidbaren Zustand (daher das Wort „Zwillingsteilchen“). Sie bilden sozusagen gemeinsam ein physikalisches (Quanten-)System, dass durch die „störende“ Messung „kollabiert“ und die beiden Teilchen sind „frei“. Die „Ursache“ der Befreiung ist die Messung eines Außenstehenden. D.h. sogar hier „transzendiert“ etwas das zu messende System, innerhalb dessen die gleichzeitige Ursache-Wirkungs-Kette abläuft, nämlich der Messende selbst. Wer aber transzendiert eine unendliche Kette verschränkter Universen? Und alle Universen müssen zuvor gleich sein („Zwillingsuniversen“), wenn sie sich gegenseitig gleichzeitig verursachen sollen. Und sie müssen in einem verschränkten Zustand gewesen sein. Dass dies alles der Fall gewesen sein soll grenzt an Absurdität. Und ob das physikalisch überhaupt möglich ist, scheint sehr gewagt, denn in unserem Universum vergeht ja definitiv Zeit, damit kann es „hinterher“ zwar theoretisch weitere Universen verursachen, doch, wie gezeigt, kann diese Kette nicht schon von Ewigkeit her bestehen. Die Annahme einer unendlichen Kette von Ursachen und Wirkungen ist also mit vielen unbeweisbaren (vgl. Axiom 3) Annahmen verbunden, deren logische Plausibilität noch nicht einmal gesichert ist (vgl. Axiom 1). Und außerdem: Wir zeigten zuvor, dass es zumindest innerhalb unseres physikalischen Universums nichts Unendliches zu geben scheint. Warum in aller Welt sollten wir da plötzlich die physikalische Realität einer unendlichen Kausalkette postulieren, ohne den geringsten Beweis dafür, wo wir doch sonst auch nirgends physikalische Unendlichkeiten entdecken? Das widerspricht massiv jeder Wahrscheinlichkeit und Plausibilität (vgl. Axiom 2).

Logisch konsistent und ohne physikalische Probleme und wilde Spekulationen ist dagegen die Annahme einer ersten Ursache (die einzige Alternative zu einer unendlichen Kette von Ursachen und Wirklungen).

Eigenschaften einer ersten Ursache

Die erste aller Ursachen ist per Definition unverursacht (sonst wäre sie nicht die erste Ursache). Wir hatten bereits gesehen, dass sie damit schon ewig existieren muss. Nun gibt es aber (mindestens) zwei Sorten von Ewigkeit: Eine „zeitbehaftete“ (unendlich lange Zeitperiode) und eine „zeitlose“ (es gibt gar keine Zeit). Die zeitbehaftete Version macht dabei wieder ähnliche Probleme wie die unendliche Kausalkette. Außerdem ist es eher wahrscheinlich, dass eine Ursache, die das Phänomen „Zeit“ verursacht hat (Zeit entstand erst mit dem Big Bang), dieselbe transzendiert (gleiches gilt übrigens auch für den Raum). Es ist daher plausibler anzunehmen, das eine erste Ursache weder Raum einnimmt, noch dass für sie Zeit „vergeht“. Augustinus bezeichnete diesen zeitlosen Zustand einmal als eine Gegenwart, die nie zur Vergangenheit wird. Es versagen allerdings alle Gleichnisse für einen solchen Zustand, denn im Prinzip projizieren wir alles in eine zeit- und raumbelastete Welt, da wir nur in diesen Kategorien denken können. Das hat sogar schon Platon erkannt, der bekanntlich unsere Zeit als die Projektion der göttlichen Ewigkeit in das „Schattenreich“ Erde als unvollständiges Abbild des Himmels ansah.

Doch wo keine Zeit, da (nach menschlichen Denkkategorien) auch keine Veränderung. Wie kann dann eine erste Ursache überhaupt etwas verursachen? Hier kann natürlich nur spekuliert werden. Doch eine Entität (die erste Ursache), die weder Raum noch Zeit einnimmt, kann nur noch spirituell erklärt werden; damit liefert eigentlich nur noch der „Wille“ dieser Entität eine hinreichende Erklärung für die Existenz von Wirkungen einer solcher ersten Ursache. Physikalisch lässt sich jedenfalls nicht erklären, wie in einem zeit- und raumlosen Dasein ohne Veränderung etwas hervorgebracht werden kann (z.B. unser Universum).

Wenn wir nun unser Universum beobachten, so gibt es zumindest für uns Menschen die Kategorien „Gut“ und „Böse“. Obwohl ich der Meinung bin, um logische Selbstwidersprüchlichkeiten bei der Verwendung der Worte „man soll“ oder „es ist besser wenn…“ etc. zu vermeiden, dass es absolute moralische Werte gibt (das Problem ist dann evtl., diese zu finden), ist dies für die nachfolgende Betrachtung irrelevant. Wichtiger ist, dass Gut und Böse nicht zwei „duale“ Dinge sind, sondern das eine eine „Korruption“ des anderen ist. „Böses“ ist die Abwesenheit von Gutem, so wie Dunkel die Abwesenheit von Licht ist. Das ist konsistent mit dem Zweiten Hauptsatz der Thermodynamik aus der Physik: Die Entropie (also die „Unordnung“ eines Systems) nimmt insgesamt ständig zu, aus Ordnung wird Unordnung. Das sind nicht zwei duale Dinge, sondern die Unordnung ist das (schlechte) Resultat der Ordnung (des Guten). Verwesung und Tod (gemeinhin als Schlecht empfunden) sind die Korruption des Lebenden. Rost ist Korruption und zugleich „Parasit“ von Eisen. Böses ist die Korruption von Gutem, ein Parasit zudem, der ohne das Gute nicht auskommt. Schlechtes ist wie eine Wunde, die den Köper braucht um überhaupt existieren zu können. Da nun die Entropie ständig im Universum zunimmt (der Mensch hat nicht unerheblichen Anteil daran diesen Vorgang zu beschleunigen), war es zu Beginn offenbar „ordentlicher“ (also „besser“). Nach diesen Maßstäben ist offenbar das Ergebnis, was die erste Ursache einst hervorgebracht hat, einmal „gut“ gewesen. Das lässt es als höchst plausibel erscheinen, dass die erste Ursache zumindest gute Absichten gehabt hat, also selbst „gut“ in diesem Sinne ist.

Des weiteren scheint sich die erste Ursache an die Logik zu halten, sonst könnten wir damit nicht unsere Realität beschrieben. Das stellt uns vor das Problem: Wo kommt die Logik her? Wurde die Logik von der ersten Ursache „verursacht“ oder gab es sie schon immer und die erste Ursache „musste“ sich dran halten? Beide Möglichkeiten führen zu Widersprüchen, die nur gelöst werden können, in dem man annimmt, das die Erste Ursache und die Logik das selbe sind. Das bedeutet aber, dass die Erste Ursache sozusagen die Logik „inkarniert“. Die Logik kann nicht „später“ hinzugekommen sein, muss also – wie die erste Ursache – schon ewig existieren und ist damit sozusagen Bestandteil der ersten Ursache.

Des weiteren folgt, das eine erste Ursache, die so etwas Komplexes wie unserer Universum hervorbringen kann, über extrem viel Wissen verfügen muss.

Fassen wir unsere durch reine Logik und Plausibilitätsbetrachtungen gewonnen Erkenntnisse über eine erste Ursache nochmals zusammen:

- Die erste Ursache existiert ewig

- Die erste Ursache transzendiert Raum und Zeit

- Die erste Ursache ist nicht materiell (Materie existiert nur innerhalb des Raumes)

- Die erste Ursache scheint über einen Willen zu verfügen

- Die erste Ursache ist „gut“

- Die erste Ursache arbeitet nach logischen Gesetzten

- Die erste Ursache ist extrem intelligent

Erste Ursache = Gott?

Die Liste an Eigenschaften der ersten Ursache legt nahe, dass es sich in der Tat dabei um eine „Person“ in der besten Definition dieses Begriffs handelt. Wer verfügt beispielsweise über einen Willen, wenn nicht Personen? Ich möchte noch einmal betonen, dass die Punkte der obigen Liste allein aus physikalischen Erwägungen bzw. naheliegenden Plausibilitätsüberlegungen entwickelt wurden. Jeder dieser Punkte für sich genommen ist so wesentlich wahrscheinlicher und plausibler wie sein Gegenteil (manches Gegenteil wäre zudem logisch unmöglich).

Wenn man sich in den sog. „Heiligen Schriften“ der Welt nach einem Gott umsieht, der diese Eigenschaften erfüllen muss, so kann man feststellen, dass eigentlich nur das Gottesbild der Schriften des Alten und Neuen Testaments der Bibel alle diese Anforderungen erfüllt.

Skeptiker werfen Theisten meistens vor, sie würden das Problem der „unerklärlichen Existenz“ sozusagen „nach draußen“ projizieren, also das eine Unerklärliche (die Welt) mit dem anderen Unerklärlichen (Gott) ersetzen. Das mag zu einem gewissen Grad sogar richtig sein, doch die Frage ist: Welche der Erklärungen ist plausibler und nicht etwa reine Spekulation? Wir sahen, dass die Annahme einer unendlichen Kette von Ursachen und Wirkungen extrem spekulativ und zudem ohne die geringste Evidenz ist. Wahrscheinlich ist sie physikalisch und logisch auch gar nicht möglich. Die Annahme eines Schöpfer-Gottes dagegen ist nicht nur plausibel, sie ist weit weniger spekulativ und vermeidet die genannten Problemfelder. Außerdem gibt es hier etwas, was andere Theorien nicht haben: Indizienbeweise für Seine Existenz. So etwa die Historizität der Auferstehung Jesus Christus, die außerordentlich gut außerbiblisch belegt ist[8].

Der Gott der Bibel erfüllt auch die Tatsache, dass er die Logik „inkarniert“. In Joh. 1.1 heißt es bekanntlich: „Im Anfang war das Wort, und das Wort war bei Gott, und Gott war das Wort.“ Im griechischen Original steht für das „Wort“ logos. Logos ist aber auch der griechische Begriff für „Logik“. Außerdem steht z.B. in Tit: 1:2, dass Gott nicht lügen kann. Dies zeigt u.a., dass auch Allmächtigkeit nur im Rahmen der Logik zu sehen ist. Der Gott der Bibel kann nichts logisch unmögliches tun. Gott transzendiert zwar unser Wissen, aber nicht die Logik.

Daneben existiert die mathematische Unmöglichkeit der Eintrittswahrscheinlichkeit der Hunderten von extrem genauen Prophezeiungen des Alten Testaments, die historisch nachprüfbar lang vor ihrer Erfüllung getätigt wurden. (Säkulare) Mathematiker haben berechnet, dass bereits die Eintrittswahrscheinlichkeit für 8 erfüllte Prophezeiungen bei 1:1017 liegt. Das entspricht ungefähr der Möglichkeit, dass ein Mensch mit verbunden Augen aus einer ca. 1 Meter hohen über die ganze Fläche von Texas bedeckte Menge von 1-Dollar-Stücken eine einzige rot gekennzeichnete darunter beim ersten Versuch „zufällig“ herausholt. Bei den Hunderten von eingetroffenen Prophezeiungen wäre die Eintrittwahrscheinlichkeit 1 gegen 10 hoch –zig Trilliarden…

Ganz zu Schweigen von der mathematischen Unmöglichkeit, dass sich die spezifisch komplexen biologischen Systeme sowie das Feintung der Naturkonstanten im Universum „zufällig“ hätten „genau richtig“ so entwickeln können wie man es braucht, um Leben zu ermöglichen.

In seiner Ganzheit betrachtet liefern diese Dinge einen hervorragenden „kumulativen“ Beweis für die Behauptung, dass die Existenz eines Gottes, speziell des Biblischen Gottes, wesentlich wahrscheinlicher, plausibler und auch rationaler ist wie die Annahme, es gäbe keinen solchen Gott. Atheisten, insbesondere die Naturwissenschaftler unter ihnen, sind gegenüber der Schwere dieser Argumentation mit Recht ratlos und versuchen durch zum Teil äußerst absurd wirkende Spekulationen irgendwie um die doch so naheliegende Schlussfolgerung der Existenz eines Schöpfers „herumzukommen“ (man betrachte z.B. die Bubble-Universe-Theorie von David Deutsch, die mit unglaublicher Spekulationsfreude und riesigem mathematischem Aufwand ohne noch nicht einmal die Andeutung eines physikalisches Beweises versucht, das Feintung der Naturkonstanten zu erklären).

Lehrt uns doch unser Axiom Nummer 3 (Occam’s Razor), die naheliegendste Theorie mit den geringsten Grundannahmen allen anderen vorzuziehen. Die Existenz eines Schöpfer-Gottes ist ganz klar die naheliegendste Erklärung für unsere Existenz mit alle seinen Facetten.

———————————————————————

Prof. Dr. Peter Zöller-Greer

Member of the New York Academy of Sciences

Fellow and Member of the International Society for Complexity, Information and Design

Awarded Member of the American Association for the Advancement of Science (AAAS)

Mitglied im Professorenforum Herausgeber des Professorenforum-Journals

Jahrgang 1956, 1972 Realschulabschluß, 1972 – 1975 Lehre als Physiklaborant (BASF AG Ludwigshafen) & Fachabitur, 1975-1981 Studium Mathematik und Theoretische Physik,(Uni Siegen und Uni Heidelberg), Abschluß als Diplom-Mathematiker , Vertiefungsgebiet: Mathematische Physik, 1981-1983 Systemanalytiker und Programmierer bei BBR Mannheim (Reaktorphysik), 1983-1987 DV-Referent für Bürokommunikation bei ABB Mannheim (ABB Informatik GmbH), 1987-1990 Musikproduzent und Komponist, Verlagsleiter eines Musikverlages, Geschäftsführer der Composia GmbH, zahlreiche Veröffentlichungen im Tonträgerbereich, Filmmusik, Fernsehen, 1990 Promotion an der Uni Mannheim (Dr.rer.nat.) über Approximationstheorie und eine numerische Anwendung auf ein Problem aus der Quantenmechanik, 1990-1993 Dozent an der FH Heidelberg, FB Informatik (Stiftung Rehabilitation). Seit 1993 Professor für Informatik am Fachbereich Mathematik, Naturwissenschaften, Datenverarbeitung an der FH – Frankfurt am Main University of Applied Sciences. Arbeits- und Forschungsschwerpunkte:

Informatik: Künstliche Intelligenz, Neuronale Netze, Fuzzy-Logic, Genetische Algorithmen, Software-Engineering, Multi-Media-Systeme.

Phsyik: Quantenphysik, Glauben und naturwissenschaftliche Apologetik

Fußnoten

[1] Kurtz, Paul et. all : “Humanist Manifestos I and II” (Prometheus, 1973) und “Humanist Manifesto 2000“, Prometheus, 2000

[2] in „The John Ankerberg Show“: Debate on Christianity vs. Secular Humanism, 1986

[3] Aspect, A. et. all in: “Physical Review Letters” (Vol. 49, p. 91 ) 1982

[4] vgl. Zöller-Greer, P. in: “Perspectives On Sciene And Christian Faith” (Vol. 52, No. 1, p.8ff) 2000

[5] Hawking, Stephen: “Das Universum in der Nußschale”, Hoffman und Campe, 2001, Seite 114ff.

[6] Dembski, William A: “No Free Lunch”, Rowman & Littlefield, New York, 2002

[7] vgl. Dembski, William A.: „Irreducible Complexity Revisited“ in Professorenforum-Journal Vol 5. No.2

[8] vgl. z.B. Zöller-Greer, Peter: „Zur Historizität der Auferstehung Jesus Christus“, in: Professorenforum-Journal Vol 1, No.2